これから学ぶ人も、資格取得を目指す人も、最適なカリキュラムを選べます。

CTC 教育サービス

[IT研修]注目キーワード Python Power Platform 最新技術動向 生成AI Docker Kubernetes

今回は、データセンターのエネルギー効率を機械学習で予測するという事例を紹介します。これは、2014年に公開された論文「Machine Learning Applications for Data Center Optimization」で解説されているもので、ニューラルネットワークを用いて、サーバーの稼働率や冷却水の温度設定によるエネルギー効率の変化を予測するというものになります。

データセンターのエネルギー効率は、一般に、PUE(Power Usage Effectiveness)という指標で計測されます。これは、「データセンター全体の消費電力 ÷ IT機器による消費電力」という計算式で表されるもので、データセンターで消費される電力がすべてIT機器によるものであれば、1.0になります。ただし、冷却設備など、IT機器以外で消費される電力もあるため、実際には1.0よりも大きくなります。PUEを出来る限り小さくして、1.0に近づけることがデータセンターのエネルギー効率改善の目標ということになります。

図1は、Googleが所有するすべてのデータセンターにおけるPUEの平均値を示したもので、青色のグラフは、四半期ごとの変化を示しています。季節ごとの変動を繰り返しながら、全体として減少を続けていることがわかります。赤色のグラフは、直近の12ヶ月分の平均値について、その変化を示したものになります。なお、GoogleのデータセンターにおけるPUEの計算では、発電や変電に関わる外部設備の消費電力も考慮されており、これらを含めない、業界で標準的に用いられている計算方法では、1.06という値を達成しています。最新の情報については、Webサイト「Google Datacenters - Efficiency: How we do it」で確認することができます。

図1 GoogleのデータセンターにおけるPUEの変化(論文より抜粋)

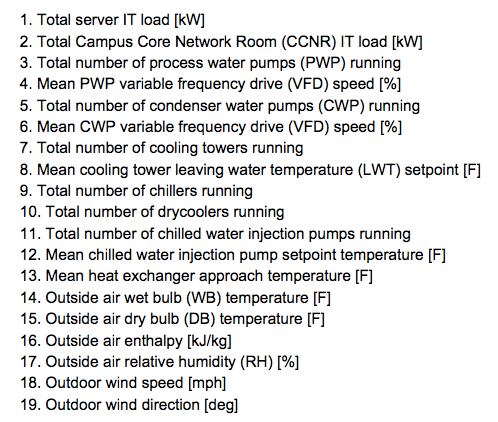

図1に示したようなPUEの改善を実現する上では、さまざまな設備の稼働状況に関するデータ収集が重要なポイントとなります。Googleのデータセンターでは、このようなデータを継続的に収集して、PUEの改善に役立ててきました。この論文では、このような蓄積データを用いて、設備の稼働状況からPUEの値を予測する機械学習モデルを作成した事例が紹介されています。具体的には、図2に示したデータを入力値(特徴量)とするニューラルネットワーク(各層に50個のノードを持つ5層からなる全結合ネットワーク)を作成して、過去2年間に渡る5分単位でのデータで学習処理を行っています。

図2 PUEの予測に使用するデータ(論文より抜粋)

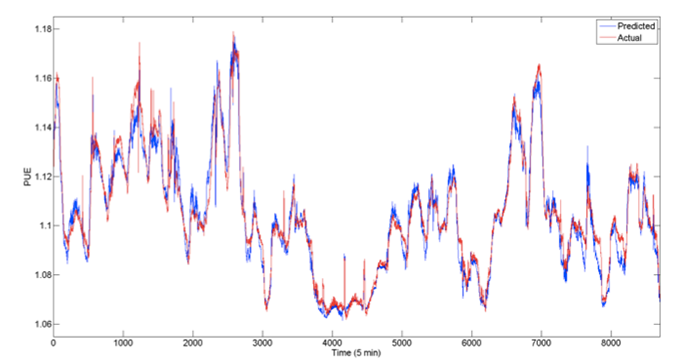

図3は、学習済みのモデルによる予測結果を実際のPUEの値と比較したもので、テスト用のデータセットに対して、絶対値誤差の平均が0.004という精度を実現しています。

図3 予測値と実際の値の比較結果(論文より抜粋)

ちなみに、機械学習で使用するモデルにはいくつかの種類がありますが、ここではなぜニューラルネットワークを使用したのでしょうか? その理由として、設備の稼働状況には複雑な関連性がある点が指摘されています。たとえば、冷却された空気が通過するコールドアイルの温度設定を変化させると、冷却水循環装置、冷却塔、熱交換器、ポンプなど、関連するさまざまな設備の稼働状況が変化します。そのため、設備の稼働データとPUEの値には、非線形の関係性が発生します。論文の中では、このような非線形の関係をモデル化して捉えるために、ニューラルネットワークを用いたとの説明がなされています。なお、図2に示したデータをニューラルネットワークに入力する際は、生の値をそのまま用いるのではなく、値の範囲を0.0〜1.0に変換する正規化処理が行われています。

論文の中では、このようにして作成した予測モデルの活用方法として、次の3つの例が挙げられています。

1. リアルタイム予測によるアラートの生成

各種設備の稼働データをリアルタイムに収集してPUEを予測することで、PUEの値が目標値を上回りそうな状況を検出してアラートを生成します。

2. PUEの計算値の異常検知

Googleのデータセンターでは、天然ガスの使用量についてもPUEの計算に含めていますが、天然ガスの計測器は地域によって出力データの内容が異なります。このような計測器の違いによるPUEの計算ミスを防ぐために、ニューラルネットワークによる予測値と実際の計算値の比較を行ったそうです。計算値が予測値から大きく外れた場合は、計算過程に何らかの問題があった事がわかります。

3. 設備設定の最適化

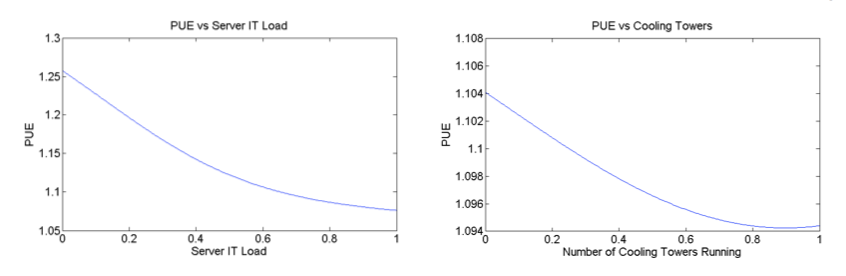

各種設備の設定を変化させた際に、PUEがどのように変化するかを予測することで、設備設定の最適化を行うことができます。わかりやすい例としては、図4のような関係があげられます。左のグラフは、サーバーの稼働率とPUEの関係を示したもので、稼働率を高めた方が全体としてエネルギー効率はよくなり、PUEの値が減少することがわかります。稼働中のサーバーと稼働していないサーバーが混在していると、効率的な冷却ができないというわけです。あるいは、右のグラフは、冷却塔の数によるPUEの変化です。冷却塔が増えるとPUEが減少するというのは不思議な気もしますが、これは、冷却塔内で稼働するファンの回転速度が原因です。冷却塔の数を増やすことで、それぞれの冷却塔のファンの回転速度を落とすことが可能になり、結果として、冷却塔全体の消費電力が減少することになります。

図4 入力値の変化に対するPUEの変化予測(論文より抜粋)

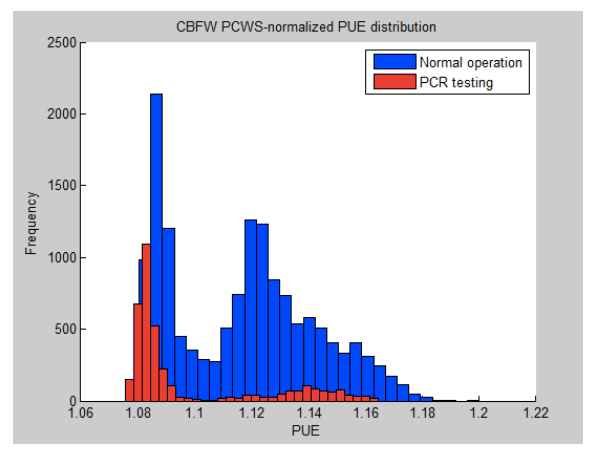

図5は、これらの分析から得られた知見を元に、PUEを改善した例になります。冷却水の温度設定を適切に増加した所、PUEの分布がより低い値に変化したことが示されています。青色のグラフが過去5年間のPUEの分布で、赤色のグラフが温度設定変更後の分布になります。

図5 PUEの改善例(論文より抜粋)

図5のグラフを見ると、PUEの分布には2箇所の山がありますが、これは、夏期と冬期の違いから来ています。夏期は、追加の冷却設備を稼働する必要があるために、冬期に比べてPUEの値が大きくなります。改善後のデータは冬期に取得したものなので、左側の山についてのみ変化を比較する必要があります。

今回は、Googleのデータセンターのエネルギー効率改善にニューラルネットワークを活用した事例を紹介しました。ここで、この論文は、2014年に公開されたものである点を強調しておきたいと思います。2016年に、DeepMindがディープラーニングを用いて、Googleのデータセンターのエネルギー効率を改善したという記事が公開されましたが、ディープラーニングを活用するためには、十分な量の学習データが必要です。Googleでは、古くからデータセンターのエネルギー効率の改善に取り組み、さまざまなデータの収集・分析を続けてきた事が、DeepMindのこのような成果へとつながったのは間違いないでしょう。

次回は、少し話題を変えて、Google社内のソースコード管理システムを紹介したいと思います。

Disclaimer:この記事は個人的なものです。ここで述べられていることは私の個人的な意見に基づくものであり、私の雇用者には関係はありません。

[IT研修]注目キーワード Python Power Platform 最新技術動向 生成AI Docker Kubernetes